Химическая физика, 2022, T. 41, № 5, стр. 281-36

Оптические методы обнаружения и слежения за движущимися объектами в атмосфере

И. Л. Фуфурин 1, *, И. Б. Винтайкин 1, А. Л. Назолин 1, Д. Р. Анфимов 1, Ил. С. Голяк 1, С. И. Светличный 2, М. С. Дроздов 2, Иг. С. Голяк 1, А. В. Щербакова 1, А. Н. Морозов 1

1 Московский государственный технический университет им. Н.Э. Баумана

Москва, Россия

2 Федеральный исследовательский центр химической физики им. Н.Н. Семёнова

Российской академии наук

Москва, Россия

* E-mail: igfil@mail.ru

Поступила в редакцию 10.01.2022

После доработки 18.01.2022

Принята к публикации 20.01.2022

- EDN: JPZCIC

- DOI: 10.31857/S0207401X2205003X

Аннотация

Прогресс в области разработки инфракрасных лазерных диодов, фотоприемных элементов матриц видимого и инфракрасного (ИК) диапазонов, а также лидарных систем позволяет применять методы оптической локации для обнаружения и сопровождения движущихся объектов в атмосфере. В первую очередь, речь идет о беспилотных летательных аппаратах (БПЛА), которые находят широкое применение во многих областях человеческой деятельности. В настоящей работе описана экспериментальная установка, позволяющая на расстоянии более 1 км обнаружить в атмосфере движущийся объект, определить расстояние до него и в автоматическом режиме осуществить его сопровождение. Установка состоит из матричного фотоприемника видимого и ИК-диапазонов, источника активной подсветки в виде лазерного диода ИК-диапазона, излучающего на длине волны λ = 808 нм с выходной мощностью 30 Вт, и инфракрасного лидарного модуля с энергией в импульсе до 15 мДж, излучающего на длине волны λ = 1540 нм. Показано, что совокупность пассивных и активных оптических методов позволяет обнаружить в атмосфере движущиеся объекты, например аэрозольные облака или БПЛА. Для автоматического обнаружения движущихся объектов различных типов в процессе обработки изображений в видимом и ИК-диапазонах используются методы глубокого обучения (сверточные нейронные сети). С помощью описанной установки на нескольких трассах протяженностью до 1 км включительно проведены оценки линейных размеров беспилотных летательных аппаратов.

1. ВВЕДЕНИЕ

В настоящее время активно развиваются методы дистанционного зондирования поверхности Земли [1], облаков [2], а также различных объектов [3, 4] и возмущений [5, 6] в отрытой атмосфере. Особенно актуальна проблема обнаружения беспилотных летательных аппаратов (БПЛА), их идентификации и автоматического слежения за ними. В последние несколько лет были рассмотрены возможности использования дистанционной локации движущихся объектов акустическими и оптическими методами, а также с помощью радаров [7]. Проведена классификация объектов по типу, размеру и техническим характеристикам и проанализированы методы их обнаружения на основе анализа радиочастотного и видеосигналов [8–10]. С целью обнаружения современных миниатюрных аппаратов типа ZALA 421-08, DJI Phantom 2 и им подобных исследованы также ограничения применимости радиолокационных систем [9, 10]. Показано, что эффективным подходом для обнаружения и идентификации подобных БПЛА служит использование методов оптической локации, в том числе совместно с датчиками, принцип действия которых основан на анализе радиочастотного спектра и акустических волн. Метод радиолокации предполагает наличие мертвой зоны на расстояниях 250–700 м от локатора, когда необходимо также применение оптических методов [11].

Для обнаружения объектов по ИК-изображению существует два подхода. В первом подходе идентификация осуществляется по собственному излучению объекта в диапазоне длин волн 7–14 мкм [12]. При этом чувствительность современных тепловизоров по яркостной температуре должна быть около 0.05 К. Их следует также оснащать трансфокаторами с кратностью объектива не менее 10×–20×. С целью обнаружения и идентификации объекта, топографирования местности и последующего выделения движущихся объектов следует применять второй подход, в котором используется активная инфракрасная лазерная подсветка, например, ИК-лазером с длиной волны λ = 903 или 1560 нм [13].

Обнаружение БПЛА на расстоянии до 2 км стало возможным благодаря использованию лазера с λ = 1560 нм, длительностью импульсов 1 нс, частотой повторения 1 МГц и мощностью в импульсе 700 кВт. Угловое поле луча лазера составляет 0.5° × 0.5°. При этом система комплектуется матричным фотоприемником (150 × 20 пикселей) и оптической системой, где поле зрения матричного фотоприемника соответствует угловому полю луча лазера. Фиксируется отраженный сигнал от летательного аппарата. Подобные системы могут оснащаться лазерным дальномером. В литературе также описывается возможность обнаружения БПЛА с помощью тепловизоров по излучению теплого воздуха, выделяемого двигателем или аккумуляторной батареей, нагреваемых в процессе работы [14].

Визуализация сигналов лидара проводится с использованием методов 3D-топографирования, например OctoMap [15]. Существует целый класс методов динамического анализа фона и выделения подвижных малозаметных объектов [16]. Так, для анализа изображений и 3D-картин (типа гиперкуб) применяют методы теории графов и нейронные сети [17]. С 2012 года в области глубокого обучения были разработаны нейронные сети, которые могут обнаруживать объекты в режиме реального времени с точностью более 90%. Наиболее популярными моделями нейронных сетей, применяемых для решения поставленной задачи, являются: Faster R-CNN (Convolution Neural Network) [18], YOLO (You Only Look Once) [19], SSD (Single Shot Detector) [20]. Каждая модель зависит от базового классификатора, влияющего на ее качество [21, 22].

Современные модели YOLO и SSD основаны на распознавании по одному полученному кадру с точностью детектирования 63 пикселя при 45 Гц развертки и 72 пикселя при 58 fps (frame per second) соответственно. В моделях, построенных на основе модели Faster R-CNN, процесс детектирования происходит в два этапа. На первом этапе проводится поиск областей матрицы с предположительными объектами. На втором этапе применяется модель Faster R-CNN, которая проводит поиск в областях, найденных на первом этапе. Недостатком данного подхода является независимое друг от друга обучение сетей. Модели YOLO и SSD решают проблему обнаружения как задачу регрессии. Высокая скорость работы данных моделей позволяет применять их в режиме реального времени для детектирования движущихся объектов.

В мировой практике помимо визуальных каналов обнаружения и слежения за подвижными объектами применяются спектральные методы исследования химического состава материала БПЛА. Для разделения на компоненты биологической и небиологической природы могут использоваться совмещенные ИК- и УФ-каналы как, например, во флуоресцентно-аэрозольном лидаре Фаран-М1 [23], в котором совмещены лазеры с λ = 266 и 1034 нм. Применение лазеров, перестраиваемых в широком спектральном диапазоне [24], позволяет генерировать излучение пиковой мощностью до 0.5 Вт, покрывая диапазон перестройки в 1000 см–1 с шагом 1 см–1 за время, не превышающее 1 с. Показана возможность обнаружения и идентификации конкретных типов химических соединений по диффузно рассеянному излучению [25]. Соотношение Крамерса–Кронига позволяет выполнять преобразования оптических характеристик, повышая тем самым селективность спектрального анализа. В 1953 г. Робинсон и Прайс были одними из первых, кто продемонстрировал, как можно получить спектры поглощения вещества путем численного преобразования спектров рассеянного света [26]. В работе [27] описаны численные методы и установка для идентификации веществ по рассеянному излучению, в том числе от одиночных капель вещества. В монографии [28] приведен обзор существующих лазерных методов анализа химических соединений. С помощью квантово-каскадного лазера (ККЛ) с перестройкой в среднем ИК-диапазоне и мощностью излучения 100 мВт/см2 путем построения гиперспектральных изображений удается обнаруживать следовые количества веществ до 10 мкг/см2 на расстоянии до 20 м [29]. В работе [30] показана также возможность создания лидаров на базе ККЛ инфракрасного диапазона для дистанционного обнаружения веществ на поверхностях.

Детектирование БПЛА принципиально может быть осуществлено и по анализу воздушного слоя вблизи него. Для этой цели используются методы мониторинга химического состава воздуха в пилотируемых космических аппаратах [31, 32] и анализ открытой атмосферы методами инфракрасной фурье-спектроскопии [33, 34].

Отдельным направлением является применение методов машинного и глубокого обучения для решения задач спектрального анализа. В работах [35, 36] описаны результаты применения машинного обучения и нейронных сетей для обнаружения (путем лазерной ИК-спектроскопии) как чистых веществ, так и компонент в газовых смесях, а также идентификации и классификации микроорганизмов различных типов.

Ранее нами была показана возможность автоматического обнаружения движущихся объектов в открытой атмосфере в условиях температурного контраста порядка 0.4° С [37]. Обнаружение проводилось в видимом и ИК-диапазонах спектра. Для распознавания использовалась сверточная нейронная сеть YOLOv4. В данной статье рассмотрены возможности применения матричных фотоприемников видимого и ИК-диапазонов, тепловизоров и лазерных дальномеров для обнаружения и сопровождения подвижных объектов. Анализ данных также проводится многослойными сверточными нейронными сетями YOLOv4.

2. ЭКСПЕРИМЕНТАЛЬНЫЙ СТЕНД

Экспериментальный стенд предназначен для дистанционной локации и сопровождения подвижных объектов, в том числе БПЛА с применением оптических методов в различных диапазонах спектра. Стенд включает следующее оборудование:

1) видеокамеру видимого и ближнего ИК-диапазонов, оснащенную трансфокатором с кратностью не менее 20×;

2) инфракрасный лазер подсветки с λ = 808 нм и выходной оптической мощностью порядка 30 Вт;

3) лазерный дальномер на длинах волн 1540–1570 нм с длительностью импульса не более 25 нс, расходимостью излучения не более 1 мрад и энергией излучения не менее 15 мДж;

4) тепловизор с порогом чувствительности не менее 60 мК при развертке 30 Гц в спектральном диапазоне 8–13 мкм.

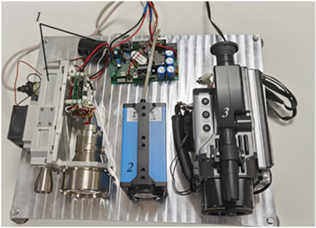

Внешний вид экспериментального макета изображен на рис. 1, на котором ИК-лазер не показан. Все компоненты стенда смонтированы на единой алюминиевой сэндвич-панели, обладающей высокой жесткостью на изгиб при малом весе. Полотно панели состоит из двух алюминиевых металлических листов, между которыми находится сотовый сердечник, также выполненный из алюминия.

Рис. 1.

Внешний вид экспериментального стенда: 1 – лазерный дальномерный модуль НТЕВ.461321.008, 2 – видеокамера видимого и ближнего ИК-диапазонов DFK 39GX265-Z20, 3 – Тепловизор NEC 2640.

В качестве лазерного дальномера используется модуль НТЕВ.461321.008 производства ООО “Квантовая оптика” (Санкт-Петербург, Россия), состоящий из лазерного твердотельного излучателя с λ = 1540 нм, приемного канала дальномера на той же длине волны приема, и источника питания и управления, содержащего в своем составе блок конденсаторов. В табл. 1 приведены основные технические характеристики лазерного дальномера.

Таблица 1.

Технические характеристики лазерного дальномера

| Наименование параметра, единица измерения | Значение |

|---|---|

| Длина волны, нм | 1540 ± 0.5 |

| Энергия излучения, мДж | не менее 15 |

| Длительность импульсов, нс | 20 ± 5 |

| Частота следования импульсов, Гц | не более 10 |

| Расходимость излучения, мрад | не более 1 |

| Диаметр выходного излучения, мм | не более 25 |

| Максимальная дистанция, км | 20 (при МДВ в 20 км) |

| Точность измерения дистанции, м | 1.5 |

| Режим работы | циклический |

| Диаметр приемного объектива, мм | 75 |

| Вес, кг | не более 2.4 |

Твердотельный лазерный излучатель выполнен в отдельном герметичном корпусе и представляет собой лазер с полупроводниковой накачкой. Излучатель имеет плоский оптический резонатор, модуляция добротности осуществляется пассивным лазерным затвором на основе кристалла Cr4+:YAG. Для накачки активного элемента применяется матрица лазерных диодов, излучающих на длине волны 808 нм. Преобразование излучения Nd–лазера в излучение с λ = 1540 нм осуществляется параметрическим генератором света на основе кристалла КТР (титанил-фосфат калия).

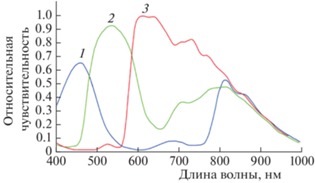

В качестве регистрирующего модуля видимого и инфракрасного излучения используется видеокамера машинного зрения DFK 39GX265-Z20, оснащенная трансфокатором с кратностью не менее 20×. Характеристики сенсора Sony IMX265LQR из состава камеры DFK 39GX265-Z20 представлены в табл. 2. На рис. 2 приведена спектральная характеристика для трех каналов (красный (3), зеленый (2) и синий (1) матрицы сенсора Sony IMX265LQR. Видно, что чувствительность сенсора позволяет одновременно работать как в видимой, так и в инфракрасной областях спектра.

Таблица 2.

Характеристики сенсора Sony IMX265LQR

| Наименование параметра, единица измерения | Значение |

|---|---|

| Динамический диапазон, бит | 12 |

| Разрешение, пикселей | 2048 × 1536 |

| Частота, кадр/с | 36 |

| Формат видео | 8-Bit Bayer (RG), 12-Bit Bayer Packed (RG), 16-Bit Bayer (RG), YUV 4:2:2, YUV 4:1:1, RGB24 |

На рис. 3 изображен внешний вид БПЛА, который использован в эксперименте, а в табл. 3 представлены его характеристики. Описанный экспериментальный стенд может регистрировать двумерные изображения объекта в видимом и ИК-диапазонах и определять расстояние до объекта. Это позволяет, используя методы машинного и глубокого обучения, проводить автоматическую локацию подвижных объектов с возможностью сопровождения последних в автоматическом режиме, а также определять линейные размеры подвижного объекта.

3. РЕГИСТРАЦИЯ И АНАЛИЗ ЭКСПЕРИМЕНТАЛЬНЫХ ДАННЫХ

Измерения выполнялись в районе поселка Красково Московской области на открытой местности, где был выбран достаточно ровный участок длиной в 1.5 км. Измерения проводились на расстояниях от 200 до 1000 м с шагом в 200 м. При этом БПЛА в заданных точках поднимался на высоту 5–10 м. С помощью камеры, работающей в видимом и ИК-диапазонах, нейронная сеть с частотой распознавания кадров в 10–20 Гц, обнаруживала объект, после чего экспериментальный стенд наводился на этот объект. Далее с помощью ИК-лидара проводилось измерение расстояния до объекта. В ночное время область предполагаемого расположения объекта дополнительно подсвечивалась с помощью ИК-лазера.

Метод анализа двумерных изображений

При анализе данных видеокамеры использовалась одноступенчатая сверточная нейронная сеть YOLOv4 [38]. Ее основной особенностью является более точное распознавание объектов при более высокой скорости обработки кадров по сравнению с другими нейронными сетями как для данной архитектуры, так и для других архитектур [37].

Архитектура модели YOLO использует сетку предопределенных окон. Для того чтобы один и тот же объект не обнаруживался несколько раз, используется коэффициент перекрытия окон. Эта архитектура работает в широком диапазоне и устойчива к помехам. Например, модель можно обучить на фотографиях, и она будет хорошо работать с нарисованными от руки изображениями. Отличительной особенностью конкретно YOLOv4 является ее способность обучаться на одном графическом ядре с использованием методов “Bag-of-Specials” [38] и “Bag-of-Freebies” [39], которые значительно повышают точность распознавания. На рис. 4 представлена общая модель нейронной сети распознавания объектов по изображениям, слои которой отвечают за следующие четыре этапа:

• основная сеть – выделение основных признаков на изображении;

• бутылочное горлышко – сбор признаков в так называемые карты признаков;

• полносвязный слой – этап предсказания с выделением той области, где расположен объект;

• разреженный слой – классификация областей распознавания.

Описание набора данных для обучения нейросети

Набор данных состоял из 6200 разнообразных изображений беспилотных объектов различного размера и типа на произвольных фоновых подложках. Обучающая и подтверждающая выборки были получены на основе картинок и видеозаписей из открытых источников и состояли из 3000 и 600 изображений соответственно. В процессе обучения нейронной сети объем данных искусственно увеличивался c помощью ряда методов, таких как вырезание и смешивание, мозаичность, увеличение/сжатие изображений, зашумление и повороты.

Тестовая выборка состояла из 2600 изображений и была заимствована из работы [40]. Обучение проводилось в среде облачных вычислений “Google Colab” на видеокарте Nvidia Tesla P100 с памятью в 16 ГБ. Тестирование обученной нейронной сети проводилось на видеокарте Nvidia GeForce 1650 с памятью в 4 ГБ и 896-ю ядрами CUDA.

4. РЕЗУЛЬТАТЫ И ИХ ОБСУЖДЕНИЕ

Определение расстояния и размеров объектов с помощью ИК-лидара

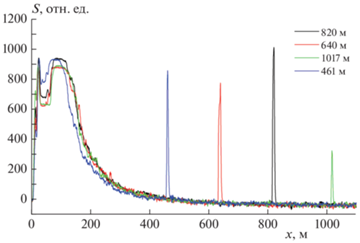

Частота получения осциллограмм составляет 10 Гц. Характерный вид таких осциллограмм представлен на рис. 5. Видно, что для расстояния в 800 м отклик ограничивается сверху динамическим диапазоном приемной системы, что указывает на возможность применения ИК-лидара для обнаружения БПЛА на значительно больших расстояниях.

Рис. 5.

Осциллограммы зарегистрированного отраженного от БПЛА сигнала, полученные с помощью ИК-лидара.

Для расстояния в 1017 м наблюдался сигнал, соответствующий границе динамического диапазона. Это не позволило получить устойчивый сигнал вне режима насыщения усилителя. Частота оцифровки осциллограмм равна 500 МГц, длина импульса – 20 нс. Пространственное разрешение по глубине ИК-лидара составляет ∼10 м, что не дает локализовать положение БПЛА по глубине. Однако описанная методика позволяет локализовать облако плотного аэрозоля в открытой атмосфере, а также исследовать его пространственную структуру в трех измерениях.

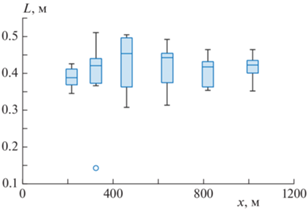

С учетом измеренного расстояния определялся угловой размер БПЛА в пикселях, который затем пересчитывался в линейный размер объекта. На рис. 6 представлены результаты определения характерного размера объекта на основе анализа видеоряда и оценки расстояния длины трассы. Зная длину трассы, угловое поле зрения одного пикселя матричного фотоприемника, а также число пикселей, которое занимает объект одновременно в двух измерениях, можно оценить размер подвижного объекта и его скорость. Здесь приведена коробчатая диаграмма оценки размеров подвижного объекта.

Наблюдаемый размер БПЛА, используемого в эксперименте, составляет от 0.29 до 0.41 м в зависимости от ориентации. Для полученных оценок максимальное значение полуширины доверительного интервала для доверительной вероятности в 95% составляет 0.07 м, что не превышает 20% от истинного размера объекта.

Результаты обучения и использования нейронной сети

Общее количество эпох обучения сверточной нейронной сети составляло 8700. Каждые 500 эпох на подтверждающей выборке рассчитывалась средняя точность. В качестве конечного набора весов для нейронной сети использовался набор с наивысшим значением средней точности (98%) на подтверждающей выборке.

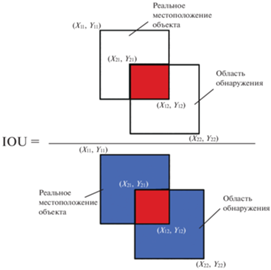

Обучение проводилось на кадре размером 416 × 416 (линейный размер приводится в пикселях (пк)). Тестирование проводилось на трех различных размерах кадра: 320 × 320, 416 × 416 и 608 × 608 пк. Из табл. 4 видно, что наибольшая точность достигается на тестовой выборке кадров размером 416 × 416 пк, что в принципе является закономерным результатом. Наименьшая точность обеспечивается при размере кадра 608 × 608 пк, но при этом на большем размере кадра точность распознавания мелких объектов повышается. Таким образом, в зависимости от размера объекта и от расстояния до него имеет смысл адаптировать размер кадра в большую сторону по сравнению с размером кадра для обучения. В качестве метрики применялась степень пересечения между двумя ограничивающими рамками IOU (Intersection-over-Union) [41] с порогом отсечки 0.5 (см. рис. 7).

Таблица 4.

Результаты срабатываний для различных размеров кадра

| Срабатывание | Размер кадра, пиксели | ||

|---|---|---|---|

| 320 × 320 | 416 × 416 | 608 × 608 | |

| Истинно положительные | 2053 | 2140 | 1875 |

| Ложноположительные | 217 | 186 | 451 |

| Ложноотрицательные | 810 | 723 | 988 |

В табл. 4 представлены результаты истинно положительных (TP), ложноположительных (FP) и ложноотрицательных (FN) срабатываний на различных размерах кадра. Средняя точность может быть рассчитана с помощью зависимости точности от полноты – площади под кривой. Точность P, чувствительность R и средневзвешенное значение точности (чувствительности) F1 могут быть получены следующим образом:

В табл. 5 приведены рассчитанные характеристики для различных размеров кадра. Из полученных результатов видно, что оптимальным размером кадра для распознавания в реальном времени является 416 × 416 или 320 × 320 пк, но при последующем увеличении до 608 × 608 пк для маленьких объектов или для объектов, находящихся на значительном расстоянии.

Таблица 5.

Результаты параметров распознавания на тестовой выборке для различных размеров кадра

| Параметр | Размер кадра, пиксели | ||

|---|---|---|---|

| 320 × 320 | 416 × 416 | 608 × 608 | |

| Частота, кадр/с | 27 | 20 | 10 |

| Средняя точность | 0.79 | 0.84 | 0.74 |

| Точность | 0.9 | 0.92 | 0.81 |

| Полнота | 0.72 | 0.75 | 0.65 |

| F1 | 0.8 | 0.82 | 0.72 |

В серии полевых экспериментов проведено распознавание БПЛА для трассы протяженностью 1 км с фокальным расстоянием объектива матричного фотоприемника в 114.5 мм и для трассы протяженностью 500 м с фокальным расстоянием в 25 и 114.5 мм. Результаты представлены на рис. 8–10. Размер кадра составлял 608 × 608 пк. На рис. 8 приведен пример успешного распознавания БПЛА нейросетью в условиях визуально похожих мешающих объектов (птиц). Путем оптимизации порога отсечки показано, что использование одного фокального расстояния в 114.5 мм позволяет достичь наилучшего распознавания для всех длин трасс. Результаты распознавания в ночное время на расстоянии 500 м представлены на рис. 11 и 12. Так, на рис. 11 распознавание происходит на фоне неба, а на рис. 12 – на фоне деревьев. В ночное время объект подсвечивается ИК-лазером.

Рис. 8.

Распознавание беспилотного объекта на расстоянии в 1000 м с фокальным расстоянием объектива 114.5 мм.

Рис. 9.

Распознавание беспилотного объекта на расстоянии в 500 м с фокальным расстоянием объектива 114.5 мм.

5. ЗАКЛЮЧЕНИЕ

С помощью экспериментальной установки, описанной в настоящей работе, проведено успешное обнаружение беспилотного летающего объекта на расстояниях 200, 400, 600, 800 и 1000 м. Обнаружение проводилось как пассивным (днем без подсветки), так и активным методом (ночью с подсветкой ИК-лазером на длине волны 808 нм с пиковой мощностью 30 Вт). В качестве математического метода для обнаружения БПЛА использовалась сверточная нейронная сеть YOLOv4, точность распознавания которой на тестовых выборках, полученных из открытых источников, составляет 84% при скорости обработки 20 кадр/с. Оказалось, что нейронная сеть, обученная на двумерных изображениях БПЛА в видимом и инфракрасном диапазонах спектра, позволяет без потери точности проводить распознавание как в дневное, так и в ночное время. Так, точность распознавания на расстоянии 500 м составляет 80–90%, а на расстоянии 1000 м – 50–55%. Разработанный алгоритм позволяет отслеживать траекторию движения беспилотного объекта за счет записи его положения на каждом кадре. Благодаря этой информации и данным о расстоянии до объекта, фокальном расстоянии, угле обзора и плотности пикселей камеры можно определить размер объекта, а также рассчитать его скорость и предполагаемую траекторию. Расстояние до беспилотного объекта определяется с помощью лазерного дальномера. Поскольку на трассе длиной 1 км отклик ограничивается динамическим диапазоном системы приема осциллограмм, то применение ИК-лидара возможно и на расстояниях, существенно превышающих 1 км. Таким образом, совместный анализ изображений БПЛА и осциллограмм ИК-лидара позволяет определить размеры, угловую скорость и направление движения подвижного объекта, что является необходимым условием для создания систем автоматического слежения за подвижными объектами.

Работа выполнена в рамках госзадания Министерства науки и высшего образования Российской Федерации (регистрационный номер 122040500060-4), поддержана программой фундаментальных научных исследований государственных академий наук на 2013–2020 годы (регистрационный номер AAAA-A18-118112290069-6) и грантом Российского фонда фундаментальных исследований № 19-29-06009 мк.

Список литературы

Голубков Г.В., Манжелий М.И., Берлин А.А. и др. // Хим. физика. 2021. Т. 40. № 3. С. 86.

Cromwell E., Flynn D. // Proc. 2019 IEEE Wint. Conf. Appl. Comp. Vision (WACV). Waikoloa: IEEE, 2019. P. 619.

Pepe M., Fregonese L., Scaioni M. // Eur. J. Rem. Sens. 2018. V. 51. № 1. P. 412.

Hammer M., Borgmann B., Hebel M. et al. // Laser Radar Technology and Applications XXIV / Eds. Turner M.D., Kamerman G.W. Proc. SPIE. 2019. V. 11005. 110050E.

Borchevkina O.P., Adamson S.O., Dyakov Y.A. et al. // Atmosphere. 2021. V. 12. № 9. 1116.

Borchevkina O.P., Kurdyaeva Y.A., Dyakov Y.A. et al. // Atmosphere. 2021. V. 12. № 11. 1384.

Nemer I., Sheltami T., Ahmad I. et al. // Sensors. 2021. V. 21. № 6. 1947.

Филин Е.Д., Киричек Р.В. // Инф. техн. телеком. 2018. Т. 6. № 2. С. 87.

Stary V., Krivanek V., Stefek A. // J. Com. Net. 2018. V. 20. № 5. P. 464.

Parker D.A., Stern D.E., Pierce L.S. U.S. Patent 9715009 B1 // USA, 2017.

Alves M.A., Folgueras L.C., Martin I.M. et al. // Proc. 2017 SBMO/IEEE MTT-S Intern. Microwave and Optoelectronics Conf. (IMOC). Aguas de Lindoia: IEEE, 2017. P. 1.

Kim B.H., Kim M.Y. // Proc. 17th Intern. Conf. on Control, Automation and Systems (ICCAS). Jeju: IEEE, 2017. P. 1692.

Kim B., Khan D., Bohak C. et al. // Sensors. 2018. V. 18. № 11. 3825.

Müller T. // Proc. Ground/Air Multisensor Interoperability, Integration, and Networking for Persistent ISR VIII / Eds. Pham T., Kolodny M.A. Proc. SPIE. 2017. V. 10190. 1019018.

Hornung A., Wurm K.M., Bennewitz M. et al. // Autonom. Rob. 2013. V. 34. № 3. P. 189.

Wang C., Wang T., Wang E. et al. // Sensors. 2019. V. 19. № 9. 2168.

Klasing K., Wollherr D., Buss M. // Proc. 2008 IEEE Intern. Conf. Rob. Automat. Pasadena: IEEE, 2008. P. 4043.

Ren S., He K., Girshick R. et al. // IEEE Trans. Pat. Analys. Mach. Intel. 2017. V. 39. № 6. P. 1137.

Redmon J., Farhadi A. // Proc. 2017 IEEE Conf. Comp. Vis. Pat. Recogn. (CVPR). Honolulu: IEEE, 2017. P. 6517.

Liu W., Anguelov D., Erhan D. et al. // Proc. Comp. Vis. (ECCV) / Eds. Leibe B., Matas J., Sebe N., Welling M. Lect. Not. Comp. Sci. V. 9905. Cham: Springer Int. Publ., 2016. P. 21.

Li X., Zhou Y., Pan Z. et al. // Proc. 2019 IEEE/CVF Conf. Comp. Vis. Pat. Rec. (CVPR). Long Beach: IEEE, 2019. P. 9137.

Girshick R., Donahue J., Darrell T. et al. // Proc. 2014 IEEE Conf. Computer Vis. Pat. Rec. Columbus: IEEE, 2014. P. 580.

Коханенко Г., Макогон М. // Фотоника. 2010. Т. 118. № 4. С. 50.

Razeghi M., Zhou W., Slivken S. et al. // Appl. Opt. 2017. V. 56. № 31. P. H30.

Goyal A.K., Wood D., Lee V. et al. // Opt. Eng. 2020. V. 59. № 9. 092003.

Robinson T.S., Price W.C. // Proc. Phys. Soc. Sec. B. 1953. V. 66. № 11. P. 969.

Fufurin I.L., Tabalina A.S., Morozov A.N. et al. // Opt. Eng. 2020. V. 59. № 6. 061621.

Скворцов Л.А. Лазерные методы дистанционного обнаружения химических соединений на поверхности тел. М.: Техносфера, 2014.

Hugger S., Fuchs F., Jarvis J. et al. // Proc. Quant. Sens. Nano Electr. Photon. XIII / Ed. Razeghi M. Proc. SPIE. 2016. V. 9755. 97550A.

Rayner T., Weida M., Pushkarsky M. et al. // Proc. Opt. Photon. Glob. Homeland Sec. III / Eds. Saito T.T., Lehrfeld D., DeWeert M.J. Proc. SPIE. 2007. V. 6540. 65401Q.

Набиев Ш.Ш., Григорьев Г.Ю., Лагутин А.С. и др. // Хим. физика. 2019. Т. 38. № 7. С. 49.

Набиев Ш.Ш., Иванов С.В., Лагутин А.С. и др. // Хим. физика. 2019. Т. 38. № 10. С. 3.

Винтайкин И.Б., Голяк И.С., Королев П.А. и др. // Хим. физика. 2021. Т. 40. № 5. С. 9.

Фуфурин И.Л., Шлыгин П.Е., Позвонков А.А. и др. // Хим. физика. 2021. Т. 40. № 10. С. 68.

Fufurin I.L., Anfimov D.R., Kareva E.R. et al. // Opt. Eng. 2021. V. 60. № 8. 082016.

Padilla-Jiménez A.C., Ortiz-Rivera W., Rios-Velazquez C. et al. // Opt. Eng. 2014. V. 53. № 6. 061611.

Golyak I.S., Anfimov D.R., Fufurin I.L. et al. // Proc. SPIE Fut. Sens. Techn. / Eds. Valenta C.R., Shaw J.A., Kimata M. Proc. SPIE. 2020. V. 11525. 115250Y.

Mahto P., Garg P., Seth P. et al. // Intern. J. Adv. Res. Eng. Techn. 2020. V. 11. № 5. P. 409.

Li Y., Lu Y., Chen J. // Autom. Constr. 2021. V. 124. 103602.

Pawelczyk M.L., Wojtyra M. // IEEE Access. 2020. V. 8. P. 174394.

Cheng S., Zhao K., Zhang D. // Symmetry. 2019. V. 11. № 9. P. 1179.

Дополнительные материалы отсутствуют.

Инструменты

Химическая физика